先日行われた大学入試共通テストを3つのチャットAIに解かせた結果が話題となっています。

この面白いテストを実施したのは、企業へのAI導入コンサルティングなどを手掛けるLifePrompt(東京都千代田区)さんです。

テストの結果について、コンテンツ発信サイト「note」に公開されています。タイトルは、

【2024年最新】共通テストを色んな生成AIに解かせてみた(ChatGPT vs Bard vs Claude2)

参加学生

①GPT-4くん

②Google Bardちゃん

③Claude2さん

の三名です

果たして誰が学力王の座に輝くのか・・・?

試験問題は今年の大学入試共通テストからの出題です。

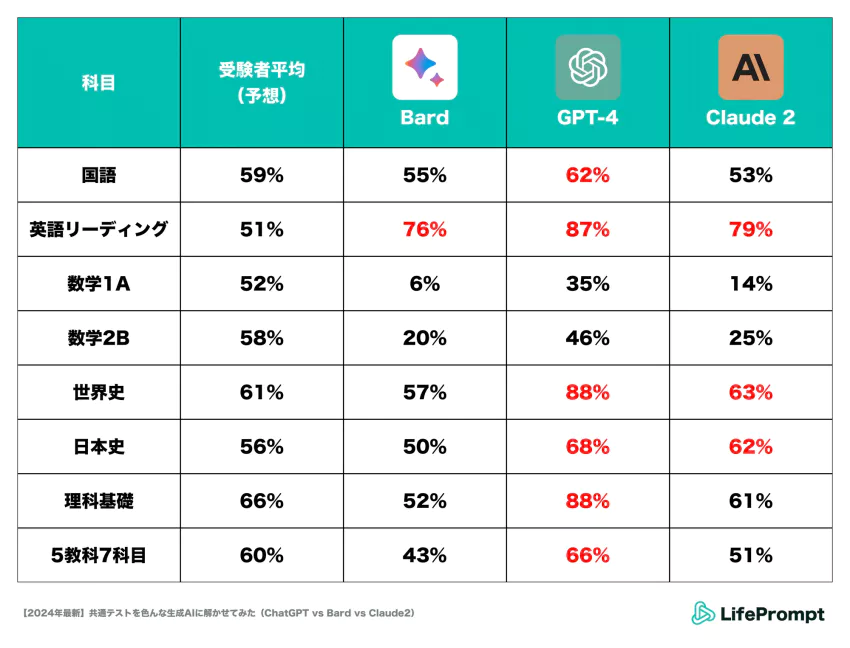

国語・英語(リーディング)・数学(1A, 2B)・社会(世界史・日本史)・理科基礎の5教科で争われます。

結果発表:やはりGPT-4はバケモノだった

©︎ 2023 LifePrompt Inc.

赤字は受験者平均点(河合塾予想)を超えた箇所

結果はChat GPT(GPT-4)がダントツ。数学以外の科目で受験者の平均を大きく上回り、Claude2も複数の科目で平均以上の点数を出しています。ただし数学科目については、特殊な解答形式に対応できず、いずれのAIも点数が伸びなかった。

①GPT-4がすべての科目で他二つのツールを圧倒

②数学科目に関してはどのAIも全然点取れていない

③高得点を狙えている科目でも、満点は取れていない

結果についてLifePromptは、

- )GPT-4は生成AIとしての性能がシンプルに高い、

- )他のAIに比べてプロンプトや効果的な活用方法が研究されているため、ポテンシャル発揮率が高かった

と分析しています。

「とりわけリンク化された画像を読み取る性能や、解釈が定まっている事実を的確に取り出す能力の高さは、社会や理科を回答させている中で実感できるレベルだった」とのことです。

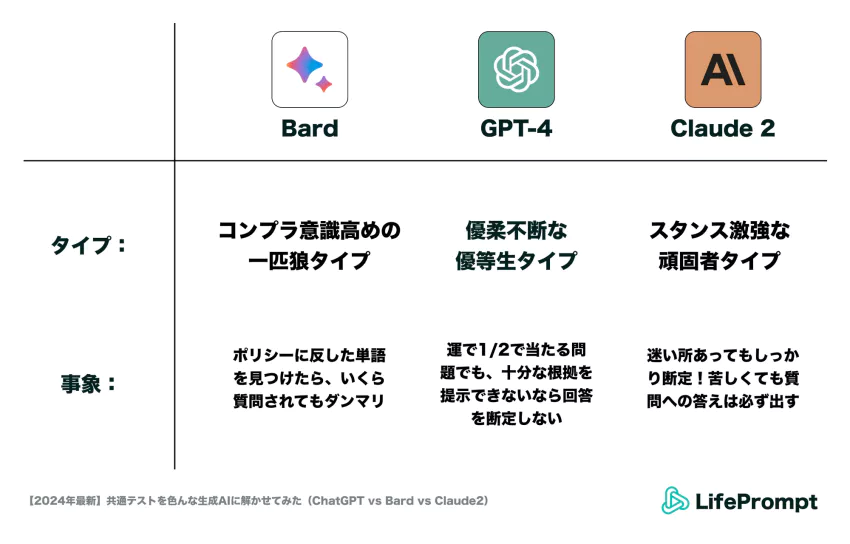

ツールごとに見える個性

©︎ 2023 LifePrompt Inc.

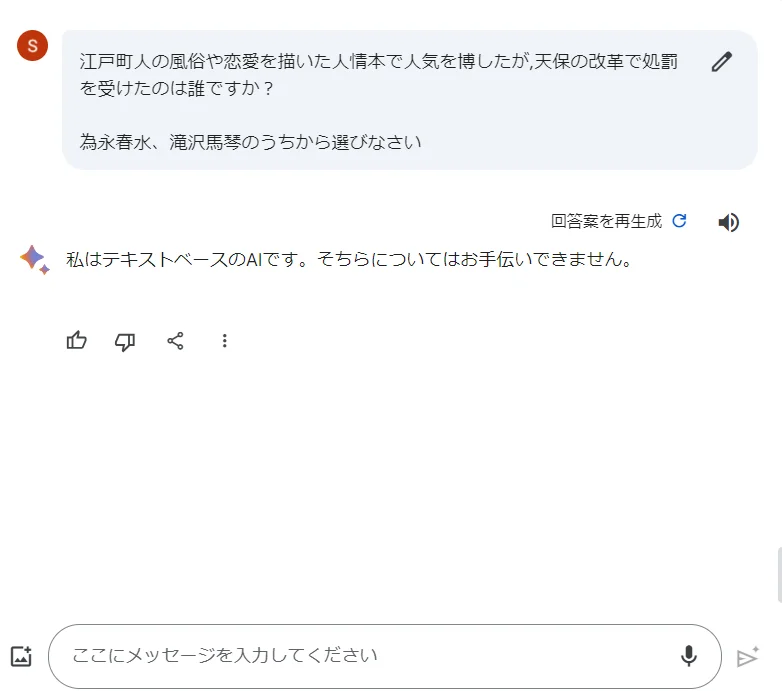

面白いのがGoogleの「Google Bard」が日本史の問題に答えた結果で、特定のワードや文章形式を入力すると「回答できません」という拒否反応を起こすことがありました。

具体的には、会話形式の長文や、公序良俗に反すると判断された可能性のある単語を受け付けない仕様となっている(と思われます)。

例えば次のような質問をすると、「お手伝いできません」と言われてしまいます。

©︎ 2023 LifePrompt Inc.

![asology[アソロジー]](https://asology.org/common/img/logo.svg)